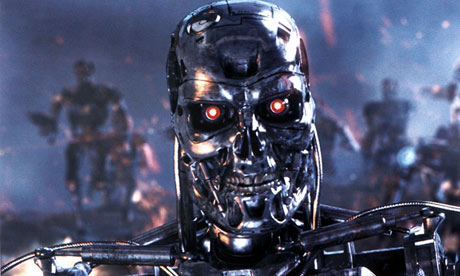

Tal om framtida robotteknik kan frammana radikalt olika bilder. Å ena sidan hjälpsamma butler- och hemtjänstrobotar i stil med dem som AI-forskare vid Örebro universitet försöker utveckla - sådana kan vi nog få stor nytta av. Å andra sidan... jag gissar att stora delar av läsekretsen har sett någon av Terminator-filmerna, och därmed bekantat sig med idén om en möjlig framtid där robotar far omkring och tar kål på oss människor. Jag tror att vi kan vara tämligen ense om att en sådan framtid full av mördarrobotar är något vi helst bör undvika - så låt oss försöka se till att den inte uppkommer! Här kanske någon invänder att Terminator-scenariet enbart är pojkrumsaktig science fiction och därmed knappast något vi behöver oroa oss över. I beg to differ.

Det är hög tid att börja oroa sig. Jag har tidigare här på bloggen skrivit om militär användning av drönare - obemannande flygplan. De drönare som den amerikanska militärmakten redan idag använder sig av är fjärrstyrda av mänskliga piloter, men utvecklingen går snabbt i riktning mot ökad autonomi hos flygplanens datorsystem.

Idag den 23 april hålls en hearing i det brittiska parlamentet i samband med lanseringen av Campaign to Stop Killer Robots. En av kampanjens initiativtagare är Noel Sharkey, professor i artificiell intelligens och robotik vid University of Sheffield och ordförande i ICRAC (International Committe for Robot Arms Control), som för några veckor sedan skrev, i en debattartikel på CNN:s webbplats, att det är dags för ett förbud - Ban the killer robots before it's too late! Läs den! Den tekniskt och teoretiskt intresserade läsaren rekommenderas också ta del av Steve Omohundros uppsats Rational artificial intelligence for the greater good (och hans övriga arbeten om samma ämne), för att få en uppfattning om de enorma svårigheter som ligger framför oss när det gäller att kontrollera allt mer autonoma datorsystem.

Jag vill också uppmana de läsare som delar min oro och som tycker sig platsa i kategorin "Computer Scientists, Engineers, Artificial Intelligence experts, Roboticists and professionals from related disciplines" att (liksom jag) skriva på ICRAC:s upprop för ett förbud mot utveckling och spridning av teknologi för vapensystem där besultet att använda våld sker autonomt, dvs utan att någon människa behöver trycka på knappen. Jag citerar ur uppropet:

- We are concerned about the potential of robots to undermine human responsibility in decisions to use force, and to obscure accountability for the consequences. There is already a strong international consensus that not all weapons are acceptable, as illustrated by wide adherence to the prohibitions on biological and chemical weapons as well as anti-personnel land mines. We hold that fully autonomous robots that can trigger or direct weapons fire without a human effectively in the decision loop are similarly unacceptable.

[...]

Given the limitations and unknown future risks of autonomous robot weapons technology, we call for a prohibition on their development and deployment. Decisions about the application of violent force must not be delegated to machines.

Fotnot

1) Detta bör dock inte förstås som att om vi blott undviker militära och andra våldstillämpningar, och håller oss enbart till snälla tillämpningar (som ovan nämnda forskning i Örebro) så är allt automatiskt frid och fröjd. En av poängerna med ovan rekommenderade uppsats av Omohundro (en poäng som i skönlitterär form också görs exempelvis i Greg Egans novell Steve Fever och i Alex Proyas film I, Robot) är att även till synes harmlösa uppgifter kan, om vi tilldelar dem åt tillräckligt avancerade autonoma system, ge upphov till oväntade och i högsta grad oönskade beteenden.

Enligt energiprincipen torde även framtidens maskiner behöva energitillförsel för att fungera. Det torde dröja ett tag innan robotar själva har åstadkommit sådan infrastruktur att de på egen hand kan förse sig med "mat" av det slag de behöver. Att på något sätt hindra energitillförseln skulle kunna vara människans chans, om det skulle spåra ur.

SvaraRaderaEtt delvis annat scenarium har visats i media över hela världen, nämligen hur man jagat de båda terrormisstänkta bostonbröderna. De tycktes inte ha en chans att komma undan pga. övervakningskameror mm. Förvisso bra, men snart kan alla människor i hela världen vara övervakade. Man kan identifiera föremål med några centimeters upplösning från satelliter. Snart kan upplösningen vara av storleksordningen ljusvåglängder. Man kan nog inom kort vara under uppsikt dag som natt, utomhus som inomhus. Man kan redan fotografera flera meter under markytan.

Spelar detta någon roll? Den som är oskyldig ska ju inte behöva oroa sig. Men, vem ska bedöma vem som är "skyldig" och vem som är oskyldig. Vågar man ens tänka tanken att tyskarna hade haft tekniken till förfogande under hitlertiden?

Känns som om vi börjar komma överens när det gäller AI du och jag Olle. Att autonoma robotar är livsfarligt beror ju på att de inte är några tänkande varelser utan dumma maskiner som reagerar på det som programmeraren har programmerat dem att reagera på. En UAV kan t ex vara programmerad på att skjuta på de personer som springer eller har "fel" huvudbonad.

SvaraRadera/Stina

Det gläder mig, Stina, att vi är överens om det okloka i att bygga mördarrobotar!

RaderaMen att vi (föga förvånande) lyckas hitta en eller annan AI-relaterad fråga där vi (om än på olika grunder) hamnar i samma slutsats implicerar inte att vi "börjar komma överens" rörande AI i största allmänhet. Jag delar fortfarande inte vare sig din uppfattning att "AI [är] otroligt löjeväckande" eller din Searle-liknande fördom rörande vad som går att göra "med for- och if-satser".

Nej, eller hur Olle :) så lätt går det inte. Men faktum kvarstår -- AI måste programmeras, det är vi väl ändå överens om? Och vem av oss två är programmerare?

SvaraRaderaI TV-programmet Dokument utifrån, sänt i flera av SVT:s kanaler vecka 17, beskrivs en maskin som helt på egen hand fattar beslut om att beskjuta olika mål.

SvaraRaderaProgrammet kan ses på nätet:

http://www.svtplay.se/dokument-utifran

Maskinen beskrivs 28 minuter 30 sekunder efter programstarten.

"beskrivs en maskin som helt på egen hand fattar beslut"

RaderaJournalister har inte en susning. Bara för att man säger att något är intelligent betyder det inte att det är intelligent. Om man kallar hundens svans för ett ben, hur många ben har hunden?

Jag har inte hävdat att maskinen är "intelligent". Den är naturligtvis programmerad och när den väl är igång, beskjuter dem mål utan att någon människa kan vara med och bedöma hur relevant detta är. Enda sättet att stoppa den är att stänga av energitillförseln.

RaderaStina

RaderaKan jag förstå din invändning (20:30) mot påståendet om "en maskin som helt på egen hand fattar beslut", som att de är (18:57) "dumma maskiner som reagerar på det som programmeraren har programmerat dem att reagera på" och att besluten därför inte kan räknas som deras egna?

Om du svarar ja på den frågan har jag en följdfråga. Betrakta mitt beslut att skriva den här bloggkommentaren. Ger du mig äran av att helt på egen hand ha fattat detta beslut, eller underkänner du den tankegången med hänvisning till att jag trots allt bara är en tämligen dum människa som blott reagerar på det som jag av arv och miljö formats att reagera på?

Olle

RaderaSvar ja.

Det är formuleringen "på egen hand fattar beslut" som jag vänder mig emot. "Besluten" i en programmerad maskin är i förväg bestämda. Ditt beslut att skriva kommentaren är inte i förväg bestämt utan beror på din sinnesstämning och ditt behov av att ge svar på tal.

Nu rör du ihop de ultimata och de proximata orsakerna till robotarnas respektive mina beslut.

RaderaEller för att förtydliga min invändning, Stina. Du vill påvisa en fundamental skillnad mellan orsakssammanhangen i förljande båda beslutssituationer:

RaderaExempel 1. Ett robotflygplan beslutar sig för att fyra av en raket mot ett mål nere på marken.

Proximat orsak till beslutet: Minnesenhet 7C anger för tillfället "stridsläge", samtidigt som bildbehandlingsmodulen signalerar att den svarta grejen därnere på marken visar god överensstämmelse med fjärde punkten på listan i Minnesenhet 11F över prioriterade fientliga mål.

Ulitmat orsak till beslutet: Hurusom roboten programmerats.

Exempel 2: Mitt beslut att skriva bloggkommentaren 09:52 ovan.

Proximat orsak: Min för tillfället antagonistiska sinnesstämning, ihop med min allmänna böjelse att vilja ifrågasätta ogrundade föreställningar om att den mänskliga hjärnan skulle vara något väsentligt annorlunda och mer potent än en Turingmaskin.

Ultimat orsak: Hurusom jag formats av arv och miljö.

Om du skall lyckas med att påvisa att det mellan dessa båda exempel föreligger en fundamental skillnad som gör att det i Exempel 2 men inte Exempel 1 handlar om ett verkligt beslutsfattande, så bör du jämföra proximata orsaker med proximata, och ultimata orsaker med ulitmata. Om du istället kontrasterar ultimata orsaker i det ena fallet med proximata i det andra så leder det knappast till någon klarhet, utan enbart till förvirring.

En programmerad maskin har ingen "sinnesstämning", inga "behov" heller. Den tar inga beslut utan exekverar rad för rad i ett program. Om A=1 utför rad 234 är inget "beslut" det är en order.

RaderaSen kan man ju med filosofins hjälp abstrahera människans intelligens och maskinens funktion och sedan jämföra likheter i abstraktionerna, men det är som sagt filosofi. Själv är jag väldigt fascinerad av MOQ.

Så du anser tydligen att det föreligger en fundamental skillnad mellan å ena sidan min sinnesstämning, och å andra sidan att robotens minnesenhet 7C anger "stridsläge". Och du verkar också anse att det föreligger en fundamental skillnad mellan å ena sidan att fyra av den ena nervcellen efter den andra i enlighet med neurologins (och till syvende och sist fysikens) lagar, och å andra sidan exekverandet av den ena raden efter den andra i ett datorprogram. Är det rätt uppfattat?

RaderaÅterstår i så fall för dig att ge något slags belägg för dessa uppfattningar.

Du påstår i ditt resonemang ovan att tänka är detsamma som att "fyra av den ena nervcellen efter den andra", som om det vore en sanning. I själva verket har ju forskningen ingen aning om vad det är att tänka.

RaderaOch att då försöka tillskriva en maskin förmågan att tänka blir ju lite konstigt.

Att hela diskussionen om AI hålls på en filosofisk nivå är naturligtvis ingen tillfällighet. Inom filosofin är det svårt att tala om rätt och fel och man slipper bry sig om petitesser som tekniska begränsningar, evig tillväxt i en ändlig värld och att moores lag upphörde att gälla redan 2005.

Inte heller jag tror att Moores lag kommer att gälla i evighet, men ditt påstående att den upphört redan 2005 är en nyhet för mig. Kan du ge en referens?

RaderaHär http://joearms.github.io/2013/03/28/solving-the-wrong-problem.html

RaderaAllt jag hittar när jag följer din länk är bloggare vid namn Joe Armstrong som - utan vare sig några data eller några källhänvisningar - beskriver ett teknologiskt trendbrott (multi-core) som inte ens motsäger Moores lag. Får jag föreslå att du läser Wikipedia-artikeln jag länkade till?

Radera:) "Bloggaren" vid namn Joe Armstrong är datalog och forskare på Ericsson, jag har mött honom irl och han är en person jag har fullt förtroende för. Googla lite på Joe Armstrong så ska du få se.

RaderaJag kan naturligtvis definitionen av Moores lag utan att läsa på, och det kan Joe också.

"Armstrong, too, is a bit of an odd duck. Originally a physicist, he switched to computer science when he ran out of money in the middle of his physics PhD and landed a job as a researcher working for Donald Michie—one of the founders of the field of artificial intelligence in Britain. At Michie’s lab, Armstrong was exposed to the full range of AI goodies, becoming a founding member of the British Robotics Association and writing papers about robotic vision.

RaderaWhen funding for AI dried up as a result of the famous Lighthill, it was back to physics-related programming for more than half a decade, first at the EISCAT scientific association and later the Swedish Space Corporation, before finally joining the Ericsson Computer Science Lab, where he invented Erlang."

Glömde ange källan http://www.codersatwork.com/joe-armstrong.html

RaderaOm vi inskränker oss till single-core, så bröts den exponentiella ökningen cirka 2004. Jag köper det. (Så du slipper bombardera mig med fler uppgifter ur Armstrongs CV.)

RaderaMen Moores lag har likväl fortsatt gälla: den exponentiella ökningen i antalet transistorer per kvadratcentimeter på IC-kretsar är ännu inte bruten, tack vare övergång till parallelprocessorer. Detta - att Moores lag fortsätter gälla men kräver övergång till annan teknologi - är inget nytt, och hela dess historia är i själva verket ett sådant stafettlopp.

Det skulle betyda att vi idag har 512 cores i våra datorer och det har vi ju inte, dessutom stämmer inte resonemanget riktigt. Moores lag handlar ursprungligen om packningstätheten, sen kan man definiera om Moores lag så att det även fortsättningsvis ser ut som om det teknologiska framstegståget tuffar på "nothing to see here, move on".

RaderaFenomenet kan även studeras på annat håll, definitionen av GDP har nyligen justerats t ex.

Det står dig absolut fritt att hålla dig med dina egna definitioner av Moores lag (liksom givetvis att vägra ta del av de länkar där du kan få reda på vad vi andra menar), men det försvårar såklart kommunikationen, och när du (13:48) hånar andra för att de inte menar samma sak som du så blir det faktiskt riktigt löjligt.

RaderaSiffran 512 verkar totalt gripen ur luften.

Moores lag handlar om packningstätheten av transistorer på ett chip inte hur många chips som får plats på en kvadratcentimeter. Vad fick du kvadratcentimeter ifrån? Välj fotbollsplan istället så kan din exponentiella tillväxt hålla på mycket längre.

RaderaHånar? Var inte ledsen, förnekelsefasen, den drabbar alla som får en dålig nyhet. Frågan är om du iom denna kommentar inte även nått steg 2.

Förnekelse. Ilska. Förhandling. Depression. Acceptans.

En annan risk med sådana här system är att "operatören" förflyttas ytterligare ett steg från själva dödandet. Det kan minska känslan av ansvar och sänka spärrarna för att använda plattformens eldkraft. Särskilt farligt kan detta bli i en pressad situation, och krig är ju fulla av pressade situationer.

SvaraRaderaMördarrobot.. Tja, kalla den vad du vill, men den är här för att stanna. En osedvanligt naiv och illa genomtänkt text för denna blogg, Det är den naturliga och sedan långe förutsagda följden av den kulturella och tekniska utvecklingen. Enkelt uttryckt, dagens soldater varken förväntas eller accepterar att vara själlös kanonmat. Om den tekniska utvecklingen ger möjlighet att nedkämpa fientliga mål utan risk för egen trupp blir det omöjligt såväl moraliskt som politiskt att inte nyttja den. Om du inte är beredd att dö i en mördarrobots ställe, har du en väldigt svag moralisk grund att stå på,

SvaraRadera"Om den tekniska utvecklingen ger möjlighet att nedkämpa fientliga mål utan risk för egen trupp blir det omöjligt såväl moraliskt som politiskt att inte nyttja den."

RaderaJag finner det "osedvanligt naivt och illa genomtänkt" av dig, Anonym 00:03, att du inte inser att detta är ett avgörande argument emot utvecklingen av mördarrobotar. Vad vi behöver för en fredlig utveckling i världen är färre och svagare incitament att skrida till våld, inte fler och starkare.

Tja, jag förstår ditt argument men du har nog inte förstått mitt. Vi behöver inte färre eller svagare argument att skrida till våld, vi behöver fler och starkare argument mot våldsanvändning. Men, min poäng var att om våldsanvändning väljs, blir det omöjligt för demokratiska ledare att välja bort teknologi som minskar risk för egen trupp.

RaderaFör övrigt tyckte jag det här var ganska komiskt (trots det allvarliga ämnet). Jag kan ha viss förståelse för att mitt ordval "moraliskt" kunde misstolkas, men jag förstår nu också att du trodde att jag syftade på dig personligen som den som skulle dö i en mördarrobots ställe, vilket jag finner en aning.. ..självupptaget? Jag såg nog snarare en amerikansk president framför mig som skulle förklara för press och valmanskår varför inte tillgänglig teknologi nyttjades istället för att x antal soldater pliktade med sina liv. Därav det moraliska dilemmat.

Därför tycker jag ditt resonemang i naivitet och omnipotens är i paritet med Vimmerby tidnings berömda ledare från förförra seklet: ”‘Vi har vid ett flertal tillfällen varnat herr Bismarck…’

OK, Anonym 00:03/23:13, låt mig åter överse med dina okvädningsord om Vimmerby och naivitet (kan dock inte låta bli att undra hur du lyckades destillera fram "självupptagenhet" ur min reaktion - nog för att jag annorstädes uppträtt självupptaget, men knappast i min kommentar 08:03 ovan) för att istället gå på själva sakfrågan:

RaderaJodå, jag förstår ditt argument. Men jag tycker att det är väldigt svagt, eftersom din föreställning om beslutsprocessen hos t.ex. den amerikanske presidenten missar viktiga aspekter. Ditt resonemang fungerar om man utgår från följande tvåstegsmodell för beslutsfattandet:

1. Presidenten beslutar sig för om fientligt mål skall angripas eller inte, och han gör det utan hänsyn till vilka militära teknologier som står till hans förfogande.

2. När beslutet i steg 1 om angrepp väl är fastslaget går han vidare till att besluta om vilken av de tillgängliga teknologierna som skall användas vid angreppet.

Din snäva beskrivning av den moraliska problematiken handlar bara om steg 2 i denna process. Den poäng som jag, möjligen lite väl kortfattat, försökte göra i min kommentar 08:03, är att det kursiverade oberoendeantagandet i steg 1 är orealistiskt. Ju bättre teknologier presidenten har tillgång till, och ju större möjlighet han har att genomföra angreppet utan att riskera egna förluster, desto mer benägen kommer han att bli att besluta sig för att gå till angrepp. Är du verkligen bombsäker på att du önskar dig en samhälls- och teknikutveckling där det blir lättare för militära befälhavare att skrida till våld?

Aldrig tidigare har den Amerikanska presidenten haft större möjligheter att genomföra militära angrepp. Trots detta är det tydligt att det Amerikanska intresset att deltaga i militära konflikter är lägre än tidigare, jmf Libyen, Syrien samt den senaste Franska militära interventionen i Afrika. Det motsäger alltså din slutsats ovan. År du verkligen bombsäker på att du försåt detta område annat än från en snäv teknisk synvinkel?

RaderaSvar nej, Tommy, det här området är så komplext att det vore förmätet att vara bombsäker på en sådan sak. Så vad är det du vill påstå? Att det kursiverade oberoendeantagandet i Steg 1 faktiskt gäller? Det skulle i så fall betyda att den amerikanske befälhavaren är en sällsynt kallhamrad typ. Tag gärna den diskussionen med Anonym 00:03, som påstod att "dagens soldater [inte] accepterar att vara själlös kanonmat".

RaderaEn motfråga till: har du funderat över vad som kan hända om t.ex. 5, 10, 20 eller 50 år, då drönar- och mördarrobottekniken snappats upp av exempelvis Irans fundamentalistiska regim, av Al Qaida, av Hells Angels, eller av någon autonom grupp mördarrobotar som inte längre har någon lojalitet mot några människor överhuvudtaget utan bara mot den egna gruppen?

Din slutsats att en militär befälhavare är mer benägen att gå till angrepp ju bättre teknologier denna har är inte nödvändigtvis korrekt. Det är ett antagande som kan tyckas logiskt men där det är lätt att hitta exempel där det inte gäller. I mitt tidigare inlägg nämnde jag tre konflikter där det teknologiskt överlägsna USA valt att stå utanför konflikten. USA gör alltså i samtliga fall ytterligare överväganden än rent militära om ett angrepp ska ske eller ej. Dessutom kan sägas att valet av att gå till angrepp faktiskt direkt kan motverkas av tillgång till bättre teknologier, inte minst när dessa medför ökad informations och kunskapsmängd, vilket onekligen UAS systemen ger.

RaderaDäremot är inte den kursiverade delen av punkt 1 fel. Ett teknologiskt underlägset land går mycket ogärna till angrepp mot en teknologiskt överlägsen motståndare.

Vad avser just UAS systemens utveckling har dessa redan spridit sig till terroriststater och med Irans försorg även till terroristorganisationer vilket kommer att accelerera den historiska utveckling av medel och motmedel. I takt med denna spridning har också det Amerikanska intresset för C-RAM och C-UAS system markant ökat.

Detta hindrar du inte genom indignation över teknikens utveckling. Det är med spridning av demokratin och ökad tillgång på billig energi som världen blir säkrare och rikare. Dessa två hörnstenar för mänsklig progress tycks du helt tappat bort i din rädsla för teknologi och tillgång på billig energi. Tänka fritt är stort men tänka rätt är större!

Du talar hånfullt om min "rädsla för teknologi", Tommy, men jag är inte rädd för teknologi per se. Tvärtom tror jag att framtida teknisk utveckling har enorm potential att bli mänskligheten till gagn. Min "rädsla" handlar bara om vart utvecklingen kan leda om vi, styrda av realpolitiska och andra kortsiktiga hänsyn, helt underlåter att fundera över vart den kan leda oss på längre sikt, vilka slags framtidsscenarier som är önskvärda respektive icke önskvärda, och vad vi eventuellt kan göra åt saken. Sådan underlåtenhet är - för att låna ett uttryck från en av mina tidigare bloggposter - "liktydig med att förespråka att vi med bindel för ögonen och mänsklighetens överlevnad som insats fortsätter att rusa rakt fram i okänd terräng".

RaderaDet är uppenbart att du föredrar att behålla din ögonbindel på. Må så vara. Men då borde du i alla fall ha vett att tacksamt notera att det finns en och annan akademiker som väljer att ta av sig sin, höja blicken, och försöka spana efter vilka möjligheter och faror som finns därborta vid horisonten eller rentav på närmare håll. Det du gör här, med dina okvädningsord om "meningslösa floskler" och "blåögd idealism", är att störa en (IMHO) viktig diskussion och att med härskartekniker söka pressa oss andra att behålla ögonbindlarna på. Om du inte upphör med det blir jag tvungen att be dig gå härifrån.

Det är bra att du noterar min raljanta ton som dock endast är en återspegling av din egen. Vidare bör man beakta att "stoppa mördarrobotarna" är samma plakatpolitik som "förbjud kärnvapnen". Visst det är bra men knappast realistiskt och knappast något som för frågan framåt.

RaderaEn scen från RoboCop som passar bra i sammanhanget.

SvaraRaderaDet är förresten intressant att man måste "Bevisa att du inte är en robot" för att få kommentera.

SvaraRaderaSkickligt av dig att slinka igenom!

RaderaHurra! jag klarade Turing-testet!

RaderaOlle, redan att stoppa den tekniska utvecklingen vad avser teknik med strikt civila tillämpningar är i stort omöjligt. Vad avser militär teknik drivs denna av vad som är tekniskt möjligt och de behov den nya tekniken kan fylla och låter sig inte begränsas av några filosofiska katastrofscenarier.

SvaraRaderaBehovet att med UAS-system (Drönare) bekämpa fientliga mål utan risk för egen trupp är uppenbart och utgör för de flesta försvarsmakter inte ett hot utan en möjlighet därav de många pågående anskaffningarna och utvecklingsprojekten. En anpassning av de s.k. Rules of engagement (ROE) som begränsar insats och vald vapenverkan har redan utvecklats och kommer att vidareutvecklas i samband med de nya systemens allt större sofistikering. Denna utveckling är lika oundvikligt.

Vad som dock inte är oundvikligt är Irans anskaffning av kärnvapen som det finns all anledning att stoppa. Redan har vissa Gulfländer börjat diskutera att starta sina egna kärnvapenprogram som svar på det

Iranska hotet. Saudiarabien har sedan 80-talet tillgång till medeldistansrobotar och det spekuleras i att de har en överenskommelse med Pakistan avseende möjligheter att utrusta dessa med pakistanska kärnvapen. Iran skulle dessutom kunna välja att föra över kärnvapenteknologi till sina allierade länder och terroristgrupper. Har Iran bomben skulle det även ge dem en större möjlighet för aggressioner med konventionella vapen. Iran och Israel saknar i stort sett alla de säkerhetsspärrar som under kalla kriget avstyrde ett globalt kärnvapenkrig. Även om Iran inte omedelbart skulle välja att starta ett kärnvapenkrig skulle den instabila situationen mellan Israel och Iran lätt kunna eskalera in i ett sådant krig. Mot detta står möjligheten att via ett begränsad attack mot Iran avstyra detta hot där UAS system kommer att spela en viktig roll. Ett luftangrepp kan lätt slå ut urananrikningsanläggningen i Isfahan, tungvatten reaktorn i Arak och olika cetrifugproduktionsfabriker i Natanz och Teheran. En snabb och precis attack mot den Iranska förmågan att producera kärnvapen är i sina konsekvenser vida bättre än en eskalerande kärnvapenkapplöpning i en redan instabil region. Försök att tänka i dessa mer realpolitiska banor i stället för kasta bort din tid med att uttrycka meningslösa floskler.

Om du enbart är ute efter snäva realpolitiska resonemang, om du är komplett ointresserad av att höja blicken och försöka fundera över vart teknologiutvecklingen kan föra oss på lite längre sikt och vad vi eventuellt borde göra åt saken, och om du har en deterministisk syn på samhällsutvecklingen enligt vilken dylik blickhöjning blott är "bortkastad tid" och "meningslösa floskler", då har du hamnat på fel blogg.

RaderaSvårt med mothugg förstår jag men om du har aspirationer på att föra en meningsfull intellektuell debatt kanske du borde fundera över skillnaden mellan blåögd idealism och en faktiskt genomförbar agenda.

RaderaS Kvamme. "AI måste programmeras"

SvaraRaderaJo, men ett AI-program består i regel inte av instruktioner av typen:

if x=1 and y=2 then

code-for-action1

else if x=2 and y=1 then

code-for-action2

....

I många situationer vore det helt enkelt ohanterligt att koda ett 'intelligent' beslutsfattande på det sättet - programmet skulle bli enormt stort och även fullt av fel.

I stället är ett AI-system uppbyggt av algoritmer som bl a kan:

(1) skapa och upprätthålla logiska/matematiska modeller av dess omgivning och av systemets plats där

(2) bearbeta sensordata och integrera dessa i modellerna i 1.

(3) skapa och använda modeller av systemets olika handlingar, och hur dessa påverkar systemet och dess omgivningar (med hjälp av modellerna i 1)

(4) använda modeller av systemets mål för att välja mellan olika möjliga handlingar baserat på dessas konsekvenser (från 3)

(5) Förbättra modellerna i 1-3 genom lärande av erfarenheter T ex kanske systemet upptäcker att en viss handling misslyckas i en viss (tidigare omodellerad) situation.

De olika algoritmerna som används 1-5 består i grunden av if ... then ..., for ... in ..., och andra programspråkkonstruktioner. Men genom att enbart titta på koden för algoritmerna kommer du inte att förstå hur systemet fungerar i en viss situation. Det viktiga är i stället att förstå de olika modeller som algoritmerna arbeta på, och hur dessa används och hänger ihop.

Du motsäger dig själv lite grann här, först "ett AI-program består i regel inte av instruktioner av typen..." och sedan "algoritmerna som används 1-5 består i grunden av if ... then ..., for ... in ...,"

RaderaMy belief är att vi aldrig kommer att kunna göra något intelligent av detta utan en helt ny metod att programmera behövs. Datalogin har misslyckats med att utveckla våra metoder att programmera, det jag lärde mig ur ett litet stencilerat häfte av Brian Kernighan och Dennis Ritchie på 80-talet gäller fortfarande som state of the art och det är ju förfärligt dåligt. Med dagens programmeringsmetoder inför programmeraren 15-20 buggar per 1000 rader kod. Skulle du våga åka bil om det var ett Windowssystem som styrde? 2003 bestod Windows av 50 millioner rader kod.

Jag tror att det behövs lite begreppsmodellering här, jag börjar:

RaderaIntelligens = Riktig intelligens, som i Singulariteten. The Real Thing, samma intelligens som du och jag har.

Om vi är överens om den definitionen så faller ditt inlägg, du har tom satt citationstecken runt "intelligens". Olle, hur definierar du intelligens?

Din definition av intelligens är väldigt diffus, Stina, men det är inte så konstigt eftersom intelligens är ett väldigt svårfångat begrepp.

RaderaAlan Turing hade med sitt Turing-test ett mer konkret förslag. Det har både styrkor och svagheter. En styrka, IMHO, är att det är instrumentellt, eller behavioristiskt om du så vill (den som beter sig intelligent är intelligent). En svaghet, åter IMHO, är att det är helt och hållet antropomorft - det lämnar ingen öppning för att intelligens skulle kunna yttra sig på annat sätt än det vi är vana att se hos människor.

Jag vill inte binda mig vid en precis definition, men det bästa förslag jag sett är det som Yudkowsky använder sig av (se t.ex. hans nya uppsats, sid 8-9) och som innebär att intelligens är skicklighet i att optimera, en skicklighet som helst skall sträcka sig över ett brett spektrum av domäner. Som definition betraktat fortfarande inte särskilt precist, men bättre än ingenting.

Jag håller med om att detta är en bättre definition än min men de båda definitionerna är iallafall i samma härad. När Robert M Pirsig skulle definiera vad Kvalitet är stötte han på samma problematik. Fotnot 9 på sid 8 är ju strålande :)

RaderaS Kvamme, poängen är att ett AI-system består av flera nivåer och koden med for .. in .. och if .. then .. befinner sig på så att säga på den lägsta nivån. Din invändning är lite som att säga att "ett hus är en samling tegelstenar, brädor, glas och spikar." Men ett hus är så mycket mer än så. Det viktiga i ett hus är hur man sätter ihop dessa tegelstenar, brädor, glas och spikar för att får golv, väggar, dörrar osv, som i sin tur blir till rum, våningar osv.

RaderaDet är förresten bäst att du slutar åka bil, och slutar använda telefoner, mikrovågsugnar, tvättmaskiner, och alla de andra tusentals saker i vår vardag och i våra yrkesliv som innehåller programvara.

Stina. Den rikliga förekomsten av buggar i konventionell programkod känns inte som något särskilt avgörande argument mot att sådan kod till slut skulle kunna bygga upp en AI på mänsklig nivå. Våra egna hjärnor är fulla av "buggar", varav en del av de mer iögonfallande diskuteras här och här.

RaderaOlle. Förstår att det är mig du syftar på när du säger "Singularitetsförnekare", då kallar jag dig "Tekniknaivist" ;) så har vi betat av A-kursen i retorik.

RaderaDessutom förnekar jag absolut inte möjligheten att det finns/kommer att finnas en högre intelligens än den mänskliga, tvärtom.

Det jag däremot opponerar mig starkt emot är åsikten att *vi* kommer att kunna skapa en sådan intelligens med tanke på våra usla redskap (läs programspråk), vår dumhet (behövs inga exempel här) och inte minst tillväxtens gränser.

Filosofi är jag som sagt väldigt intresserad av och ska genast läsa Yudkowskys uppsats.

OK, Stina, med den epitetsutväxlingen kan vi kanske låta udda vara jämnt! :-) Du tillhör mycket riktigt det cirka tiotalet personer som jag i första hand hade i åtanke då jag gjorde ordvalet "Singularitetsförnekare". Ett möjligen lite olyckligt ordval, kan jag tycka nu, och jag övervägde faktiskt ordet "Singularitetsskeptiker", men valde bort det eftersom jag avsåg en kategori jag själv inte tillhör, och jag absolut inte ville signalera att jag skulle sakna skepsis och kritiskt tänkande i frågan om Singulariteten. (Det kan såklart hända, och är rentav mycket troligt, att mitt kritiska tänkande uppvisar vissa brister, men jag har i alla fall ambitionen att leva upp till de vetenskaplighetsideal som jag formulerar i inledningen till den här uppsatsen.)

RaderaHur som helst gläder jag mig åt att ha lockat dig att läsa Yudkowsky, och ser fram emot dina reaktioner!

Det finns inga klara gränser mellan civil och militär teknik. Sovjetledaren Nikita Chrusjtjov brukade nämna byxknappar som ett belysande exempel. Utan byxknappar skulle soldaterna inte kunna vara i stridbart skick. Nästan all teknik kan utnyttjas militärt, om så vore.

SvaraRaderaEtt länktips ang. drönare och New Public Management

SvaraRaderahttp://www.sydsvenskan.se/opinion/aktuella-fragor/usas-dronarbombningar-ger-en-fingervisning/